Hoe werkt een zoekmachine?

Bij het leren over SEO sla je al snel een hele belangrijke stap over. Vaak is dit het begrijpen van de werking van een zoekmachine. Het klinkt zo vanzelfsprekend en we gebruiken ze elke dag. En toch is het niet altijd duidelijk hoe zoekresultaten tot stand komen. Dit is ook niet raar, want zoekmachines zijn immers erg geheimzinnig over de details.

Wat we wel weten over zoekmachines, is dat zij werken met algoritmes. Een algoritme is een opeenvolging van stappen. Bij zoekmachines wordt dit gedaan door een bot. Wat deze bot precies meeneemt, is niet openbaar bekend. Wel is duidelijk welke hoofdstappen er plaatsvinden. Deze zijn als volgt:

- Crawlen

- Indexeren

- Ranken

Crawlen

Crawlen wordt gedaan door een crawler. Google heeft hiervoor GoogleBot en Yahoo heeft BingBot. Zo heeft elke zoekmachine een eigen crawler. Bots, net als robots of spiders, zijn andere namen voor crawlers.

Bij het crawlen verkent GoogleBot nieuwe en geüpdatet webpagina’s. Deze worden verzameld en toegevoegd aan de Google Index. Dit is de database van Google.

Nieuwe websites en pagina’s vinden

Maar hoe vindt Google nieuwe websites en pagina’s? De zoekmachine heeft een database gekregen door eerdere crawls. De bot checkt deze pagina’s op links die naar andere websites gaan. Zo ontdekt hij nieuwe websites. Hierom is het ook belangrijk om je linkprofiel goed op orde te hebben.

Wat als pagina’s niet gevonden mogen worden?

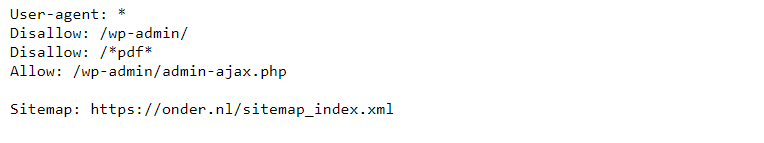

Als een crawler of spider een nieuwe website vindt, begint hij bij het robots.txt-bestand dat op de website staat. Dit is fijn, want hoewel crawlers je vrienden zijn, hoeven zij niet alles te weten.

Wil je dat een pagina of groep van pagina’s niet wordt gecrawld? Zet deze dan in het robots.txt bestand. Een crawler kan dit bestand gemakkelijk vinden omdat deze altijd op dezelfde plek staat. Voorbeelden van pagina’s die je mogelijk liever niet gecrawld wilt hebben, zijn URLs met parameters. Dit kan namelijk dubbele content veroorzaken. Ook kunnen gehele websites uitgesloten worden. Dit wordt vaak gedaan bij testomgevingen.

Let op: wanneer pagina’s een interne link binnen de website hebben, dan worden ze mogelijk nog wel geïndexeerd. Google kan namelijk ook informatie afleiden van de link naar de pagina toe.

Je eigen Robots.txt bekijken? Ga dan naar jeeigendomein.nl/robots.txt.

Na het robots.txt-bestand gaat een crawler alle interne links af om een beeld te krijgen van de gehele website. Hierdoor is het noodzaak om naar elke (belangrijke) pagina een link te hebben.

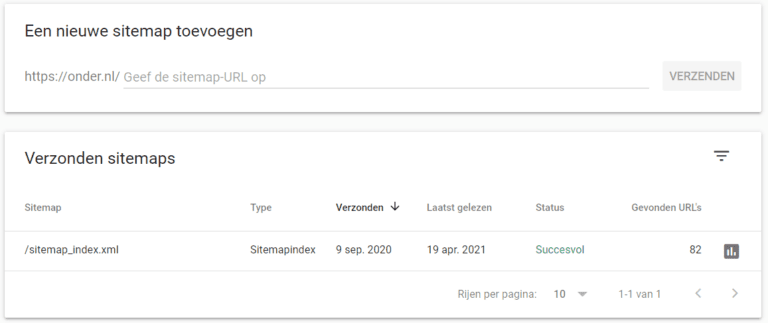

De zoekmachine helpen

In tegenstelling tot de Robots.txt verschilt de locatie van de sitemap wel per website. Het is daarom ook handig om in de robots.txt de sitemap van de website te vermelden. Een andere manier om je sitemap bekend te maken bij Google is om deze direct aan te melden in Google Search Console. Wanneer een nieuwe of geüpdate pagina een interne link ernaar toe heeft wordt, deze automatisch gecrawld. Wil je dit versnellen? In Search Console kunnen ook individuele webpagina’s worden ingediend.

Indexeren

Voordat je iemand voorstelt aan je vrienden wil je die persoon beter leren kennen. Google vind dit ook belangrijk. Voordat de website tussen de zoekresultaten verschijnt, kijkt de zoekmachine eerst waar de verschillende pagina’s van de website over gaan. Dit heet indexeren.

Google gaat dan per pagina deze verder crawlen op zoek naar meer links en indexeren. De zoekmachine rendert dan elke pagina zoals een browser dit doet en analyseert deze pagina’s. Google simuleert dan een gebruiker en kijkt zowel naar alle content als de visuele layout. Aan de hand hiervan bepaalt de bot in welke zoekresultaten de webpagina terecht moet komen. Om een geheel beeld te creëren doet de zoekmachine dit twee keer. Hiermee kan de bot kijken hoe de website presteert op zowel mobiel als desktop. Omdat deze versies kunnen verschillen, is vaak ook een (klein) verschil te zien in de uiteindelijk resultaten van de webpagina’s.

Bij het indexeren kijkt de zoekmachine dus naar de content van de webpagina. Hierbij is niet alleen de tekst belangrijk, maar ook eventuele afbeeldingen en videos. Google heeft wel een voorkeur voor tekst, omdat de bots deze content makkelijker kan begrijpen. Om de zoekmachine te helpen, zijn attributen zoals alt-teksten belangrijk.

Indexatie checken

De verkregen gegevens vanuit het indexeren worden bewaard in een database. Die van Google wordt ook wel de Google-Index genoemd. Wanneer gebruik wordt gemaakt van Google Search Console kan ook informatie vanuit de Google-Index worden bekeken en aangevraagd. Om snel de status van een specifieke pagina te achterhalen kan je gebruikmaken van de inspectietool.

Wil je weten hoeveel webpagina’s van een specifieke website ongeveer geïndexeerd zijn? Zoek op Google naar site:https:/eendomein.nl. Wil je snel kijken of een losse pagina geïndexeerd wordt? Voer dan in plaats van de homepagina een specifieke pagina in zoals site:https:/eendomein.nl/eenblogpost

Ranken

Google probeert gebruikers het beste resultaat in de vorm van webpagina’s te laten zien. Dit is natuurlijk op basis van hun zoekopdracht. De zoekmachine kijkt hiervoor naar verschillende factoren. Google zegt dat zij meer dan 200 factoren meenemen bij de beoordeling van pagina’s.

Onder deze factoren vallen onder meer de gebruikservaring, autoriteit en laadtijd van de website, maar ook de locatie en het apparaat van de gebruiker. Hiermee kiest Google de meeste relevante webpagina uit de Google-Index. De volgorde wordt bepaald ook aan de hand van deze factoren.

Aan de slag met zoekmachineoptimalisatie

Wanneer een website gevonden kan worden, wordt het tijd om deze te optimaliseren. Door websites te optimaliseren op alle factoren waar een zoekmachine naar kijkt, worden deze nog beter vindbaar. Hierdoor krijgt een website meer organisch verkeer. Doormiddel van technische seo.

Zoals eerder besproken zijn de details van de factoren die Google gebruikt bij het beoordeling van een website niet openbaar. Wel zijn een aantal richtlijnen bekend. Zelf aan de slag met je website? Maak het jezelf makkelijker en maak gebruik van een checklist zoals onze SEO content checklist.

Share

Categorieën

Heb je vragen?

Neem contact op! :) wij helpen je graag verder met al je SEO vragen

SEO vraag stellenMis het niet

Meld je aan voor onze nieuwsbrief en mis geen enkele SEO tip

"*" geeft vereiste velden aan