Indexdekking in Search Console: de SEO control room van je website

Iedereen die wel eens in een auto rijdt kent het moment: er gaat ineens een oranje lampje branden op je dashboard. Voor mij tegenwoordig een reden om vrij vlot naar een autogarage te gaan. Om er daar achter te komen dat er vrij weinig aan de hand is. Zo’n oranje lampje geeft een melding over een te verwachten probleem in je auto. Er zijn ook rode lampjes, die vaak een serieus probleem melden waarbij het niet handig is om door te rijden. Best handig dat je dashboard deze meldingen geeft, want anders zou je gewoon stil komen te staan zonder iets te weten.

Search Console heeft ook zo’n dashboard, het indexdekking rapport. Inclusief oranje en rode ‘lampjes’! Maar ook met een boel aanvullende informatie. Het indexdekking rapport is één van m’n favoriete Search Console dashboards bij grote websites. We vertellen je uiteraard graag waarom!

Crawling en indexering

Er zijn twee processen die fundamenteel zijn in je SEO succes:

- Crawling > het ontdekken van URLs door GoogleBot

- Indexing (indexeren) > het interpreteren en evalueren van informatie die op de pagina staat en bepalen of de pagina in de index komt

Op het moment dat één van deze twee processen in de soep loopt of niet zo lekker loopt heb je gewoonweg minder succes in de zoekmachine. Het indexdekking rapport in Search Console geeft je de informatie om deze processen te verbeteren en/of problemen op te lossen.

Indexdekking

Indexdekking geeft informatie over het aantal pagina’s van je website in de index van Google. En het aantal URLs dat niet in de index te vinden is. Het rapport zelf bestaat uit vier statussen (in willekeurige volgorde):

- Geldig (groen) > dit zijn URLs die in de index van Google te vinden zijn

- Uitgesloten (grijs) > dit zijn URLs die Google kent, maar niet in de index van Google te vinden zijn

- Fout (rood) > dit zijn URLs die een belangrijk issue hebben in crawling of indexering

- Geldig met waarschuwing (okergeel of oranje) > dit zijn URLs die een minder belangrijk issue hebben in crawling of indexering

Indexdekking vertelt je dus veel over het crawlproces en de indexering van je URLs. Je kunt dit zien als een soort van gegeven, maar je kunt als SEO specialist het indexdekking rapport ook gebruiken om het crawlproces en indexeringsproces te optimaliseren. Je wil immers zoveel mogelijk URLs die waarde toevoegen in de index krijgen. En de energie van Google daar ook echt op laten focussen, in plaats van GoogleBot veel URLs laten crawlen die er niet toe doen.

Optimaliseer je crawling en indexing, dan zul je merken dat je content + linkbuilding werkzaamheden veel meer effect hebben!

Indexdekking optimaliseren: status ‘Uitgesloten’

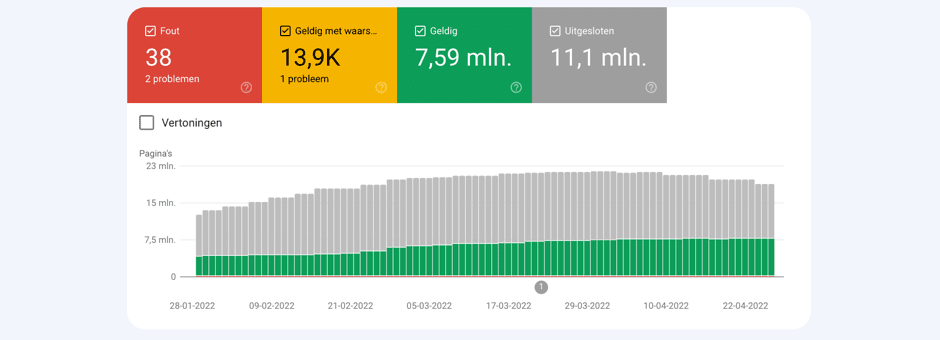

Het is natuurlijk niet zo dat elke URL die onder ‘Uitgesloten’ te vinden is ook direct een probleem oplevert. Een URL die een redirect geeft is natuurlijk prima en moet ook niet in Google staan. Toch zijn er een aantal meldingen onder ‘Uitgesloten’ waar je daadwerkelijk iets mee kunt. Het zijn niet zozeer statuscodes van URLs, maar meldingtypes van URLs die uitgesloten zijn. Een flink uit de kluiten gewassen website ziet er qua Indexdekking soms als volgt uit:

De meldingen waardoor wij regelmatig in de startblokken schieten:

Dubbele pagina’s

Dit is een soort combinatiemelding, want de melding komt twee keer voor op een bijna soortgelijke wijze. Je moet echt heel goed kijken om Dubbele pagina’s zonder door de gebruiker geselecteerde canonieke versie en Dubbele pagina, Google heeft een andere canonieke URL gekozen dan de gebruiker te onderscheiden.

Deze melding geeft aan dat Google vindt dat er sprake is van duplicate content binnen een website en/of dat de canonical tag die je hebt gespecificeerd voor bepaalde URLs genegeerd wordt. Over duplicate content verschillen de meningen en er is al veel over geschreven, ook door ons. Een grote mate van duplicate content zou je strafpunten opleveren bij Google of negatief werken. Zo kijk ik zelf niet naar duplicate content. Het is meer dat er in het voorbeeld uit het screenshot hierboven dus meer dan 800.000 URLs gecrawld zijn die geen waarde toevoegen volgens Google. Je kunt daar in mijn optiek twee kanten mee op:

- Je zorgt dat URLs met duplicate content unieker worden en daardoor waarde toe gaan voegen aan Google

- Je vindt een patroon in de duplicate content URLs uit het overzicht en sluit een groot deel van dit soort URLs uit met Robots.txt. Google crawlt de URLs vervolgens niet meer (terecht, want geen toegevoegde waarde aan de index)

Gecrawld – momenteel niet geïndexeerd

Dit is een hele lastige status, omdat het niet een hele duidelijke melding is. Het komt er op neer dat de URL wel gecrawld is, maar niet geïndexeerd. En daar kunnen meerdere redenen voor zijn:

- Vertraging in de indexering (daar heeft Google helaas het afgelopen jaar wel vaker last van)

- Duplicate content (vergelijkbaar met de melding die we hiervoor bespraken)

- Pagina voldoet niet aan de richtlijnen qua kwaliteitseisen van Google

Als deze melding veelvuldig voor komt analyseren we de URLs die in Search Console als voorbeeld te vinden zijn. Op het moment dat er een duidelijk patroon is in een set URLs kun je tot actie overgaan. Door bijvoorbeeld een reeks URL parameters uit te sluiten in Robots.txt.

Gevonden – momenteel niet geïndexeerd

Bij deze melding kent Google de URL al wel, via bijvoorbeeld een XML Sitemap. Maar heeft GoogleBot besloten om de URL nog niet te crawlen. Het kan best zijn dat dit binnen de kortste keren wel het geval is, maar over het algemeen zien we deze melding voorkomen in hele grote websites waar Google ook een gigantisch aantal URLs moet crawlen. Dit duidt dan vaak op crawlbudget issues.

Niet gevonden (404)

Dit is de welbekende statuscode ‘Niet gevonden’. Op het moment dat je onder ‘Uitgesloten’ in de Indexdekking een boel URLs hebt die 404 zijn, betekent dit dat Google nog veel historie heeft in URLs die eigenlijk niet meer bestaan. Hier kun je ook twee kanten mee op (it depends, zeg maar):

- De 404 URLs analyseren en de meest belangrijke URLs redirecten naar relevante bestaande pagina’s

- De 404s onder ‘Uitgesloten’ negeren, want het is nou eenmaal logisch om een niet meer bestaande pagina een 404 statuscode te geven

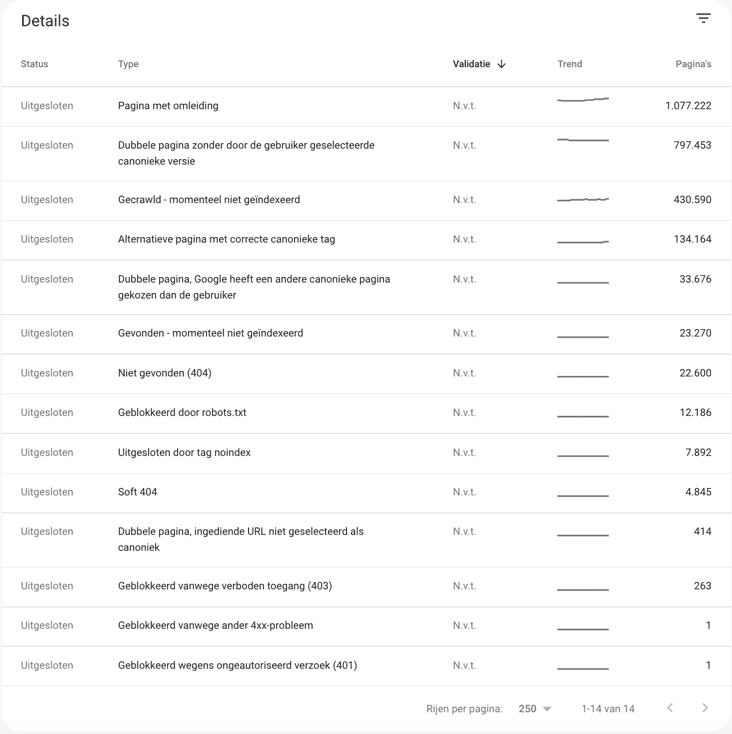

Ik hou zelf, met name in het begin van een SEO traject, van de ‘clean sheet’. Op het moment dat je 404s oplost die in het verleden linkwaarde en SEO waarde hebben gehad verbeter je het crawlen en stuur je Google naar URLs die er toe doen. We zien met enige regelmaat bij het broken backlink overzicht in Ahrefs ook waardevolle URLs staan die dus een 404 statuscode hebben: hier gaat dus linkwaarde verloren!

Uitgesloten door tag noindex

Deze melding is natuurlijk logisch: Google sluit URLs uit die de meta robots noindex of X-robots noindex tag hebben. En daar is niks mis mee. Maar helaas is ook dat niet altijd het geval. We komen vaak genoeg websites tegen waar belangrijke pagina’s voorzien zijn van een noindex. Uiteraard per ongeluk. Zaak om die lijst met URLs goed te analyseren en te achterhalen of dit allemaal klopt.

Soft 404s

Dit zijn URLs waarvan Google eigenlijk vindt dat ze een 404 statuscode zouden moeten hebben. Dit gebeurt vaak bij bestaande pagina’s die qua content echt niets te bieden hebben en dus eigenlijk een lege pagina zijn. Dit is natuurlijk geen handige situatie. Je lost dit op door unieke content aan deze URLs toe te voegen of ze gewoon uit te sluiten.

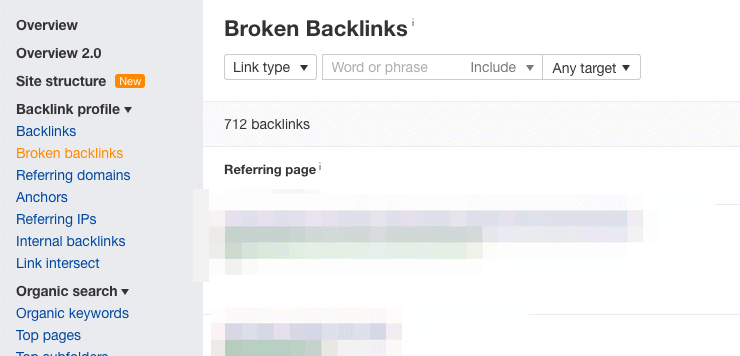

Indexdekking optimaliseren: Geldig met waarschuwing

Mijn kleurenkennis is niet uitmuntend, dus ik schat dat deze status een soort van okergeel is (kleurcode = #F4B400). Voor het verhaal maken we er in dit geval oranje van. Het draaide immers om de waarschuwingslampjes van je dashboard. Dit meldingtype houdt in dat Google URLs in z’n index heeft staan, maar dat er issues zijn met de URL op het gebied van crawlen en/of indexeren.

Geïndexeerd, maar geblokkeerd door Robots.txt

Deze melding is er één die we zelf ook wel eens expres forceren. In feite betekent dit dat Google de URLs geïndexeerd heeft, maar dat het Robots.txt bestand de URLs wel uitsluit van crawlen. Bij websites die we nog niet zo goed kennen pluizen we dit altijd goed uit. Er zijn genoeg websites die bijvoorbeeld UTM tags uitsluiten van crawlen, terwijl deze wel op allerlei websites gebruikt worden en de linkwaarde daarmee vergroten.

Pagina geïndexeerd zonder content

Dit is een hele zeldzame melding en betekent zoiets als een pagina die wel geïndexeerd is, maar waarvan Google door allerlei problemen de content niet heeft weten te interpreteren. Het kan dan gaan om een lege pagina of een pagina die niet te renderen is door Google. Op het moment dat je dit zelf test (door bijvoorbeeld de URL in Search Console live te testen) en je ziet wel de juiste content, dan kun je het issue valideren.

Indexdekking optimaliseren: rode lampjes

Het rode lampje betekent dat je niet ver mag rijden, als we het over auto’s hebben. De soep wordt niet zo heet gegeten als ze wordt opgediend in het geval van Search Console, want het is natuurlijk niet zo dat je website uit Google valt door deze meldingen. Deze melding vertelt je echter wel dat er pagina’s zijn die niet geïndexeerd zijn door serieuze fouten. Degene die we het meeste tegenkomen:

500 errors

Deze meldingen betekenen dat Google tegen server errors aanloopt die plaatsvinden bij het ophalen van de pagina. Op het moment dat dit veelvuldig plaatsvindt kan dit schadelijk zijn voor crawling. Contacteer je developer om dit te fixen!

Fout met omleiding

Bij deze meldingen ziet Google dat er een fout plaatsvindt binnen URLs met een redirect. Dit duidt vaak op redirect loops, dus als een redirect eigenlijk gewoon naar zichzelf verwijst. Maar er zijn ook andere oorzaken mogelijk. Probeer de URLs die hier genoemd worden te crawlen en te checken waar het fout loopt. En pas vervolgens de redirects in je CMS aan. Of vraag de developer om dit te doen als je hier geen mogelijkheid voor hebt.

Ingediend…

De overige meldingen die we hier vaak tegenkomen zijn meldingen die al eerder benoemd zijn, maar alleen relevant zijn voor ‘ingediende URLs’. Een ingediende URL is een URL die te vinden is in één van je XML Sitemaps. Dit is ook de manier om de kwaliteit van je XML Sitemaps te checken, want ook voor XML Sitemaps zelf kun je de indexdekking bekijken. Wij worden nooit zo blij van XML Sitemaps vol met 404s, URLs met een noindex of andere statuscodes (behalve 200 OK).

Keep the car running

Ik heb bij onze eerste auto een keer vrij lang een oranje lampje genegeerd, waarna de motor in de soep liep en de auto total loss werd verklaard. Dit had voorkomen kunnen worden als ik naar de garage ging. Niet alleen voor een periodieke keuring, maar ook voor een kleine beurt of een grote beurt. Allemaal werkzaamheden die bedoeld zijn om je auto in een goede conditie te houden, zodat de motor goed blijft draaien en er niets kapot gaat.

Wat ons betreft kun je je website ook als je auto zien. Als website eigenaar is het ook slim om bijvoorbeeld elk kwartaal de indexdekking te analyseren en maandelijks even snel te checken of er niets in de soep lijkt. Maak het een onderdeel van je SEO strategie. Zo’n periodieke indexdekking keuring kan er maar zo voor zorgen dat je website qua crawling en indexering niet stil komt te staan!

Heeft dit blog je aangewakkerd om met meer technische punten aan de slag te gaan? Download dan onze gratis technische SEO checklist met de belangrijkste punten.

Share

Categorieën

- (Content)marketing

- AI (Artificiële Intelligentie)

- Analytics

- Conversieoptimalisatie

- EEAT

- How to/DIY

- Interview

- Linkbuilding

- Nieuws

- Overig

- Technische SEO

Heb je vragen?

Neem contact op! :) wij helpen je graag verder met al je SEO vragen

SEO vraag stellenMis het niet

Meld je aan voor onze nieuwsbrief en mis geen enkele SEO tip

"*" geeft vereiste velden aan