SEO tools: onze crawling toolset en handige tips om je website te crawlen

Crawl, crawlen of crawling. Nee, we hebben het niet over de wereldberoemde hit van Linkin Park en al helemaal niet over wat baby’s zo’n beetje vanaf maand 6 doen. In deze context bedoelen we met ‘crawling’ één van de belangrijkste processen van de zoekmachine. Want zonder het crawlproces zou een zoekmachine niet bestaan. Het crawlen van URLs betekent niets anders dan het volgen van hyperlinks en het ontdekken van (nieuwe) URLs en wijzigingen. Crawling tools bootsen dit proces na, wat je in staat stelt om SEO problemen te achterhalen. De gemiddelde crawling tool gaat (gelukkig) nog wel iets verder. In dit artikel lees je meer over onze crawling toolset en handige tips om je website te crawlen met deze crawling tools.

Crawling tools

We hebben in eerdere artikelen uitgelegd hoe een zoekmachine werkt en het crawlproces is daar een belangrijk onderdeel van. Crawling tools bieden je de mogelijkheid om het proces van GoogleBot na te bootsen. Dit houdt in dat je met een crawler alle hyperlinks op een website volgt, zodat je elke URL op een website ontdekt. Een dergelijke simpele crawl stelt je in staat om veel verschillende SEO elementen die een URL bezit te achterhalen.

Er zijn veel verschillende crawling tools, waarvan wij er zelf enkele gebruiken. We kunnen onderscheid maken tussen twee verschillende type crawling tools:

- Crawling tools die op je eigen device draaien, zoals Screaming Frog en Sitebulb

- Crawling tools die in de cloud draaien, zoals Deepcrawl, ContentKing, Botify en Oncrawl. Maar tegenwoordig ook de crawlers die onderdeel zijn van de all-in-one SEO tools, zoals Ahrefs en Semrush

Over het algemeen is het zo dat een crawling tool die op je eigen device draait wat beter geschikt is voor kleine websites en het ‘quick and dirty’ crawlen. De cloud-based crawlers zijn wat beter geschikt voor het periodiek crawlen van grotere structuren.

Onze crawling toolset: Screaming Frog, Sitebulb, Deepcrawl en ContentKing

Op dit moment gebruiken we bij Onder vier crawling tools: Screaming Frog, Sitebulb, Deepcrawl en ContentKing.

Screaming Frog

Screaming Frog is de meest toegankelijke crawling tool en waarschijnlijk ook wel de meest bekende crawling tool in de SEO wereld. En natuurlijk de crawling tool met het beste en meest herkenbare logo. Het is een snelle crawling tool die je downloadt en dus op je eigen device draait.

Screaming Frog is gratis tot 500 URLs, maar je mist dan wel belangrijke features. Denk aan het koppelen van Search Console data en Google Analytics data aan je crawl. De betaalde versie kost 149 Britse ponden, zo’n € 180 per jaar. En is daarmee verreweg de goedkoopste beschikbare crawling tool.

Screaming Frog is onze beste vriend als het gaat om:

- Het controleren van doorgevoerde redirects, door een lijst met ‘oude’ URLs en/of 404s te crawlen. Je hebt snel overzicht of je redirects werken

- Snel checken of elke URL een self-referencing canonical tag heeft

- Het ‘extracten’ van bepaalde On-page info, zoals SKUs die alleen in productpagina content te vinden zijn

Het nadeel van Screaming Frog is dat de tool nogal traag wordt als er meer dan duizenden URLs gecrawld moeten worden.

Sitebulb

Sitebulb draait ook op je desktop of laptop, maar is ook geschikt voor grote structuren met veel URLs. Een voordeel van Sitebulb is de gebruiksvriendelijke interface en wat ons betreft ook de diepte qua hints (adviezen over je website n.a.v. de crawl). Sitebulb zit echt boordevol informatie, reports en URL overzichten.

Deze tool is ook relatief goedkoop met z’n € 29 per maand voor de meest uitgebreide versie.

Wij vinden Sitebulb vooral fijn als het gaat om:

- De Search Console integratie waarin je in één oogopslag ziet welke zoektermen er bij welke URLs horen

- De scores (audit score, SEO score, security score en page speed score) die je te zien krijgt na een crawl. En het pauzeren van crawls + automatisch laten opslaan van crawls

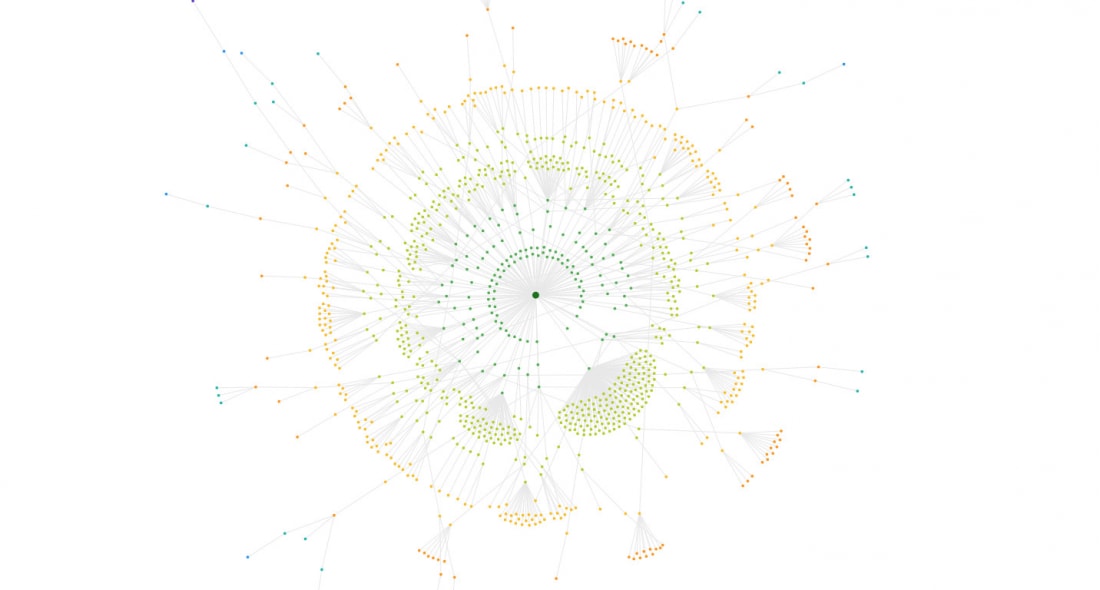

- Het visualiseren van een interne linkstructuur, wat er in het geval van Sitebulb indrukwekkend uitziet. Je kunt in de visualisatie eenvoudig zien of bepaalde clusters mooi gegroepeerd zijn en of interne linkwaarde goed verdeeld is:

Deepcrawl

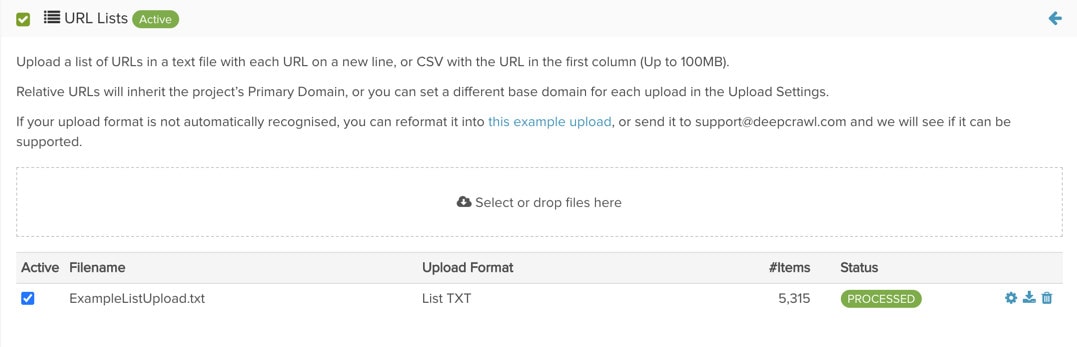

Deepcrawl is een cloud based crawling tool en nog steeds mijn persoonlijke favoriet uit onze toolset. Het is wat mij betreft de ideale crawling tool om grote structuren mee te crawlen. 500.000 URLs crawlen is geen probleem en dat heb je bij de grotere websites gewoonweg nodig. Een ander groot voordeel is het toevoegen van een URL lijst aan je crawl. Deze URL’s worden dan als extra URL’s meegenomen met de crawl.

De crawl resultaten van Deepcrawl zijn erg overzichtelijk en intuïtief voor de wat meer technische SEO specialist. Deepcrawl is een relatief dure crawling tool, de prijs is sinds een aantal jaren op aanvraag (Gelukkig draaien we nog op een fee van een aantal jaren geleden. Vertel het niet door aan de salesafdeling!)

Deepcrawl overtuigt ons vaak als het gaat om:

- De snelle overview die je krijgt in het dashboard, ideaal om snel pijnpunten te achterhalen (bvb. scheve verhouding indexeerbare URLs vs. niet-indexeerbare URLs)

- De al eerder genoemde URL list input, ideaal bij migraties. Wat is er nou fijner als net na livegang de nieuwe website crawlen, waarbij je alle oude URLs als URL list upload?

- De vergelijkingen met eerdere crawls, waarbij je een snel overzicht hebt van URLs die er sinds je vorige crawl bij zijn gekomen. Of issues die zijn gestegen ten opzichte van een voorgaande crawl (in het rapport ‘Changes’)

ContentKing

ContentKing is in tegenstelling tot de andere crawling tools in onze set een realtime crawling tool. Dat wil zeggen dat ContentKing zelf in de achtergrond realtime crawlt. En dat is best handig! Ik heb bijvoorbeeld organisaties meegemaakt waarbij praktisch realtime gereleased wordt. Zonder aankondiging wordt er een nieuwe versie van de website gelanceerd, waardoor er wel eens iets stuk gaat. Door realtime crawling kom je daar snel achter.

Een voordeel van ContentKing is dat het overzichtelijk is, ook voor de niet-technische SEO specialist. We delen ContentKing bijvoorbeeld ook met een aantal content managers van klanten. ContentKing is ook gunstig qua prijs, want je betaalt voor het aantal URLs dat je trackt, al vanaf € 29 per maand

ContentKing is wat ons betreft vooral konings als het gaat om:

- De real-time crawling die je in staat stelt om vervelende wijzigingen en fouten in site releases snel te achterhalen

- De historische gegevens die ContentKing heeft per URL. Dit stelt je in staat om bijvoorbeeld te checken welke meta title je een jaar geleden live had staan

- De health score die je website krijgt van de tool. Hoewel dit natuurlijk niet perse correleert met SEO succes (het is meer een hygiëne score), is het wel een mooie manier om websites met elkaar te vergelijken. Zo hebben we zelf in het verleden onder een groep websites de taart challenge gehad: de hoogste health score kreeg een appeltaart!

Handige tips om je website te crawlen

Het is natuurlijk niet gezegd dat bovenstaande crawling tools uniek zijn in wat ze kunnen, ze hebben echter op dit moment de voorkeur binnen ons team. Er zijn veel verschillende toepassingen mogelijk met crawling tools, die je ook zeker zelf kunt proberen met de crawling tool uit je eigen toolset. Ik denk dat we qua verschillende toepassingen wel tot een 50-tal gaan komen, dus we beperken ons tot de wat ons betreft meest handige tips! Dus het echte hygiëne werk (dode links vinden, orphans vinden) slaan we over.

Migratie: het crawlen van je nieuwe website incl. een lijst met oude URLs

Migraties zijn een belangrijk onderdeel van SEO, want je wil immers niet je traffic kwijtraken na de overgang naar een nieuwe website. Gelukkig zijn er crawling tools. Op het moment dat je een redirect file hebt gemaakt (waarin dus alle oude URLs staan die gaan veranderen in de nieuwe situatie) is het zeer comfortabel om deze in de nieuwe website mee te laten crawlen. Je wil immers dat alles op de juiste manier geredirect is. Dat kun je op twee manieren aanpakken:

- Je crawlt een lijst met URLs, wat bijvoorbeeld in Screaming Frog vrij eenvoudig uit te voeren is

- Je uploadt een lijst met URLs die je toevoegt aan een crawl, wat wij voornamelijk met Deepcrawl doen. In ContentKing is dat ook gelukt, maar dat komt met name doordat de support behoorlijk goed is (geen standaard feature)! Vervolgens crawl je de nieuwe website en alle URLs die daarin te vinden zijn en heb je direct een totaalbeeld van 404s die nog bestaan

Migratie: het vergelijken van een testomgeving met de live omgeving

Een testomgeving is dé plek om SEO elementen te testen tijdens de bouw van een nieuwe website. Het crawlen van een een testomgeving is dan ook echt de moeite waard. Het stelt je in staat om de live omgeving te vergelijken met de test omgeving, zodat je in ieder geval met een verbeterde SEO setup live kan gaan. En als de migratie op hetzelfde domein plaats vindt kun je op de testomgeving ook je redirects testen. Een testomgeving is natuurlijk afgeschermd over het algemeen. Er zijn meerdere manieren (in meerdere crawling tools) om de testomgeving toch te crawlen:

- IP whitelisting: er zijn testomgevingen waarmee je alleen met een bepaald IP adres toegang krijgt. Je kunt dan je eigen IP adres (Screaming Frog draait bijvoorbeeld op je eigen IP adres) laten whitelisten. Of natuurlijk het IP adres van je crawling tool zelf

- Robots.txt overschrijven of negeren: een Robots.txt bestand negeren is de manier om uitgesloten pagina’s wel te crawlen met je crawling tool. Daarnaast geeft een Deepcrawl ook de mogelijkheid om je Robots.txt bestand te overschrijven

- Login meenemen: sommige testomgevingen zitten verstopt achter een login. Veel crawling tools hebben de mogelijkheid om deze credentials in te geven, zodat de crawling tool alsnog de testomgeving crawlt

Content of code: het extracten of zoeken van content of onderdelen uit je code per URL

Extraction en ook Search zijn twee toepassingen die in praktisch elke crawling tool aanwezig is tegenwoordig. We leggen het uit aan de hand van Screaming Frog, omdat dit voor ons nog steeds de tool is waarbij Search & Extraction het meest laagdrempelig is.

Custom Search is vooral handig als je bepaalde content in je website zoekt. Als voorbeeld hebben we de webshop eigenaar die graag wil weten welke producten een ‘Out of stock’ melding hebben op de pagina. Je stel dan eenvoudig een Custom Search filter in, crawlt vervolgens de website en ziet welke URLs deze melding hebben.

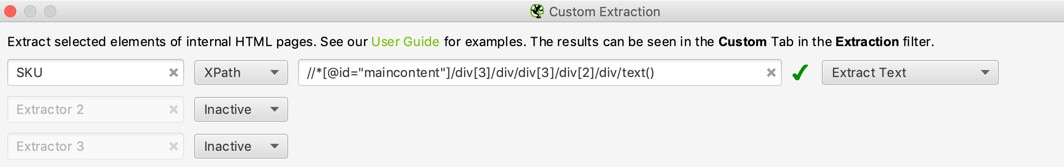

Custom extraction gaat nog wat verder. Enkele maanden geleden hadden we voor een webshop bijvoorbeeld alle interne product ID’s nodig die alleen in de content van de productpagina te vinden waren. Met custom extraction kun je dan de invulling van een bepaald element per URL laten zien. Dit element kies je door de Xpath of CSS selector in te vullen, die je uit de code haalt:

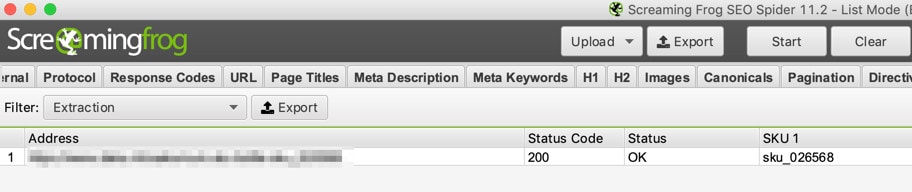

Vervolgens crawl je de URLs en zie je vervolgens de invulling van dit element in een extraction veld terug:

In ons geval was dit zeker handig, want we moesten oude product URLs op basis van dit ID met een regel redirecten naar de nieuwe product URLs.

Het al dan niet laten crawlen van URL parameters

Een URL parameter is een toevoeging aan een URL die in sommige gevallen SEO waarde toevoegt, maar soms ook niet. Denk aan Domein.com/categorie?page=2, Domein.com/categorie?t=23231, Domein.com/categorie?gclid=32732, Domein.com/categorie?utm_source=wikipedia en Domein.com/categorie?kleur=zwart. Bij een relatief kleine website gebruik je vaak een canonical tag om een URL parameter zonder toegevoegde waarde uit de index te houden. Dat betekent in de praktijk dus wel dat Google de URL nog steeds crawlt.

Bij grote websites met grote structuren kan het crawlen van URL parameters problemen opleveren. Je wil immers niet dat veel van de energie van Google naar URLs gaat die geen waarde toevoegen. De beste manier om te achterhalen welk percentage van de gecrawlde URLs een URL parameter heeft is wat mij betreft nog steeds een log file analyse. Maar een uitgebreide crawl biedt ook uitkomst. Vervolgens heb je in één oogopslag duidelijk hoeveel van de gecrawlde URLs een URL parameter of een specifieke URL parameter bevatten:

Je kunt vervolgens actie ondernemen. Wat we zelf vaak doen in dit geval is Robots.txt gebruiken, zodat de URL parameter die niets toevoegt ook niet meer gecrawld wordt.

Periodiek crawlen van je website

SEO is en blijft een continu proces. Bij grotere websites waar veel stakeholders bij betrokken zijn gaat er op veel vlakken nog wel eens wat mis. URLs worden veranderd zonder redirect, teksten worden weggehaald of SEO elementen vallen door een release om. Dit zijn toch vaak onderdelen die je pas in een later stadium ontdekt. Daarom adviseren we ook echt om periodiek je website te crawlen, zodat je eventuele wijzigingen en verbeterpunten tijdig achterhaalt. En dat hoeft echt niet met een prijzige crawling tool, Screaming Frog is gratis tot 500 URLs. Doe er je voordeel mee!

Ben je benieuwd wat Onder als SEO adviesbureau voor jou kan betekenen? Bekijk eens al onze SEO diensten, vraag naar de mogelijkheden of neem deel aan een SEO training.

Share

Categorieën

- (Content)marketing

- AI (Artificiële Intelligentie)

- Analytics

- Conversieoptimalisatie

- EEAT

- How to/DIY

- Interview

- Linkbuilding

- Nieuws

- Overig

- Technische SEO

Heb je vragen?

Neem contact op! :) wij helpen je graag verder met al je SEO vragen

SEO vraag stellenMis het niet

Meld je aan voor onze nieuwsbrief en mis geen enkele SEO tip

"*" geeft vereiste velden aan